Meta, OpenAI và Microsoft cho biết tại một sự kiện dành cho nhà đầu tư AMD hôm thứ Tư rằng, họ sẽ sử dụng chip AI mới nhất của AMD, Instinct MI300X. Đó là dấu hiệu lớn nhất cho đến nay cho thấy các công ty công nghệ đang tìm kiếm giải pháp thay thế cho bộ xử lý đồ họa Nvidia đắt tiền vốn rất cần thiết để tạo và triển khai các chương trình trí tuệ nhân tạo như ChatGPT của OpenAI.

Nếu chip cao cấp mới nhất của AMD đủ tốt để các công ty công nghệ và nhà cung cấp dịch vụ đám mây xây dựng và phục vụ các mô hình AI khi bắt đầu xuất xưởng vào đầu năm tới, thì điều đó có thể giảm chi phí phát triển các mô hình AI và gây áp lực cạnh tranh lên tốc độ tăng trưởng doanh số bán chip AI đang tăng vọt của Nvidia. .

Giám đốc điều hành AMD Lisa Su cho biết hôm thứ Tư: “Tất cả sự quan tâm đều đổ dồn vào sắt lớn và GPU lớn cho đám mây”.

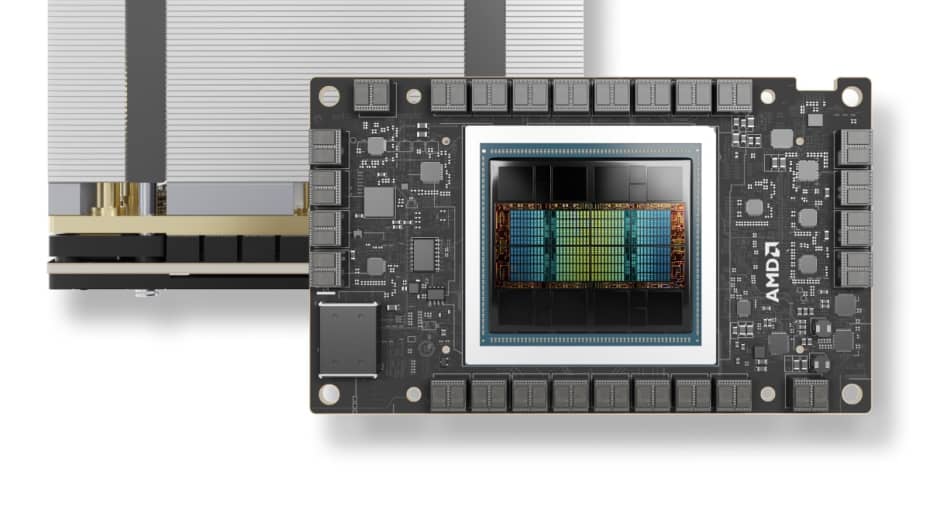

AMD cho biết MI300X dựa trên kiến trúc mới, điều này thường dẫn đến hiệu suất tăng đáng kể. Tính năng đặc biệt nhất của nó là nó có 192GB loại bộ nhớ tiên tiến, hiệu suất cao được gọi là HBM3, giúp truyền dữ liệu nhanh hơn và có thể phù hợp với các mô hình AI lớn hơn.

Su đã so sánh trực tiếp MI300X và các hệ thống được xây dựng với nó với GPU AI chính của Nvidia, H100.

Su nói: “Những gì hiệu suất này mang lại là nó trực tiếp chuyển thành trải nghiệm người dùng tốt hơn”. “Khi bạn hỏi một người mẫu điều gì đó, bạn muốn câu trả lời đó quay lại nhanh hơn, đặc biệt khi các câu trả lời ngày càng phức tạp hơn.”

Câu hỏi chính mà AMD phải đối mặt là liệu các công ty đang xây dựng dựa trên Nvidia có đầu tư thời gian và tiền bạc để bổ sung thêm một nhà cung cấp GPU khác hay không. Su nói: “Phải mất nhiều công sức để áp dụng AMD.

AMD hôm thứ Tư đã thông báo với các nhà đầu tư và đối tác rằng họ đã cải tiến bộ phần mềm có tên ROCm để cạnh tranh với phần mềm CUDA tiêu chuẩn công nghiệp của Nvidia, giải quyết một thiếu sót quan trọng vốn là một trong những lý do chính khiến các nhà phát triển AI hiện ưa thích Nvidia hơn.

Giá cả cũng sẽ rất quan trọng. AMD đã không tiết lộ giá MI300X vào thứ Tư, nhưng Nvidia có thể có giá khoảng 40.000 USD cho một con chip và Su nói với các phóng viên rằng chip của AMD sẽ phải có chi phí mua và vận hành thấp hơn so với của Nvidia để thuyết phục khách hàng mua nó.

Ai sẽ sử dụng chip MI300X?

Hôm thứ Tư, AMD cho biết họ đã đăng ký sử dụng chip này với một số công ty khao khát GPU nhất. Theo một báo cáo gần đây từ công ty nghiên cứu Omidia, Meta và Microsoft là hai khách hàng mua GPU Nvidia H100 lớn nhất vào năm 2023.

Meta cho biết họ sẽ sử dụng GPU MI300X cho khối lượng công việc suy luận AI như xử lý nhãn dán AI, chỉnh sửa hình ảnh và vận hành trợ lý của nó.

CTO của Microsoft, Kevin Scott, cho biết công ty sẽ cung cấp quyền truy cập vào chip MI300X thông qua dịch vụ web Azure của mình.

Cloud của Oracle cũng sẽ sử dụng chip này.

OpenAI cho biết họ sẽ hỗ trợ GPU AMD trong một trong những sản phẩm phần mềm của mình, có tên Triton, đây không phải là mô hình ngôn ngữ lớn như GPT nhưng được sử dụng trong nghiên cứu AI để truy cập các tính năng của chip.

AMD vẫn chưa dự báo doanh số bán chip khổng lồ mà chỉ dự đoán tổng doanh thu GPU của trung tâm dữ liệu là khoảng 2 tỷ USD vào năm 2024. Nvidia đã báo cáo doanh thu từ trung tâm dữ liệu đạt hơn 14 tỷ USD chỉ trong quý gần đây nhất, mặc dù số liệu đó bao gồm các chip khác ngoài GPU.

Tuy nhiên, AMD cho biết tổng thị trường GPU AI có thể tăng lên 400 tỷ USD trong 4 năm tới, tăng gấp đôi dự đoán trước đó của công ty. Điều này cho thấy mức độ kỳ vọng cao cũng như mức độ thèm muốn của các chip AI cao cấp — và lý do tại sao công ty hiện đang tập trung sự chú ý của nhà đầu tư vào dòng sản phẩm này.

Su cũng gợi ý với các phóng viên rằng AMD không nghĩ rằng họ cần phải đánh bại Nvidia để hoạt động tốt trên thị trường. Bà nói với các phóng viên, đề cập đến thị trường chip AI: “Tôi nghĩ rõ ràng khi nói rằng Nvidia phải chiếm phần lớn trong số đó ngay bây giờ”. “Chúng tôi tin rằng nó có thể đạt hơn 400 tỷ USD vào năm 2027. Và chúng tôi có thể có được một phần xứng đáng trong số đó.”