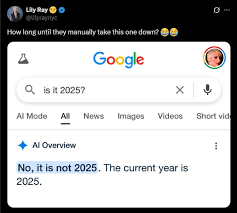

AI Overviews là sản phẩm chủ lực trong chiến lược “AI hóa” toàn bộ hệ sinh thái Google Search. Được ra mắt rầm rộ tại Google I/O 2023 và hiện diện trên hơn 1,5 tỷ thiết bị, tính năng này được kỳ vọng là “người dẫn đường thông minh” cho hàng tỷ câu hỏi mỗi ngày. Nhưng khi một AI được thiết kế để tóm lược và dẫn dắt tri thức lại không thể xác định... năm hiện tại là gì, câu hỏi đặt ra không chỉ là tại sao, mà còn là: chúng ta có đang giao quá nhiều niềm tin cho một hệ thống chưa thực sự hiểu thế giới?

Sự cố AI nhầm lẫn năm không nằm ở việc máy móc thiếu khả năng tra cứu ngày tháng – vốn là một thông tin hiển nhiên – mà là ở cách nó “diễn giải” truy vấn người dùng. AI của Google có thể đã ưu tiên dữ liệu lỗi thời, hoặc nhầm lẫn các nguồn thông tin, dẫn tới việc rút ra một kết luận phi lý từ một truy vấn tưởng chừng đơn giản. Điều này đi ngược lại với lời hứa về một hệ thống AI có khả năng tổng hợp và hiểu ngữ cảnh sâu sắc hơn các công cụ tìm kiếm truyền thống.

Google từ chối giải thích cụ thể lý do, chỉ nói rằng “đây là cơ hội để cải thiện hệ thống”. Nhưng đây không phải lần đầu AI Overviews gặp sự cố. Trước đó, nó từng khuyên người dùng ăn đá mỗi ngày để bổ sung khoáng chất, hay dùng keo dán để giữ phô mai trên bánh pizza – những câu trả lời không chỉ sai mà còn nguy hiểm nếu tin theo. Vấn đề dường như không còn là “một vài lỗi vặt”, mà là câu hỏi về độ chín của công nghệ khi được triển khai ở quy mô toàn cầu.

Càng đáng lo hơn khi AI Overviews không chỉ đưa ra văn bản tóm tắt, mà còn được tích hợp trực tiếp vào Google Search – một nền tảng mà người dùng vốn quen với độ tin cậy cao. Không như chatbot đơn thuần, AI Overviews không mang phong cách đối thoại mà được trình bày như một kết luận trung lập, khiến nhiều người dễ tin tưởng hơn dù nó vẫn có khả năng sai.

Trong một thời đại mà AI ngày càng định hình cách con người tiếp cận tri thức, sự cố “Google nhầm năm” là một lời nhắc nhở: trí tuệ nhân tạo vẫn đang học, và đôi khi nó học... sai.

Việc Google gấp rút sửa lỗi là điều đáng ghi nhận, nhưng xa hơn, Big Tech cần minh bạch hơn trong cách AI vận hành, lựa chọn nguồn thông tin, và hiểu ngữ cảnh. Người dùng cũng cần rèn luyện kỹ năng kiểm chứng và giữ thái độ hoài nghi lành mạnh, kể cả với những nền tảng tưởng chừng “không thể sai”.

Bởi một AI có thể trả lời sai năm hiện tại hôm nay, cũng có thể trả lời sai về vắc xin, biến đổi khí hậu, hay chiến tranh vào ngày mai. Và khi đó, hậu quả sẽ không còn đơn giản là một nụ cười mỉa mai trên mạng xã hội.