Trong một tòa nhà văn phòng không được đánh dấu ở Austin, Texas, hai căn phòng nhỏ chứa một số ít nhân viên của Amazon đang thiết kế hai loại vi mạch để đào tạo và tăng tốc trí tuệ nhân tạo. Các chip tùy chỉnh này, Inferentia và Trainium, sẽ cung cấp cho khách hàng AWS một giải pháp thay thế để đào tạo các mô hình ngôn ngữ lớn của họ trên GPU Nvidia, vốn đang trở nên khó mua và tốn kém.

“Cả thế giới muốn có nhiều chip hơn để thực hiện AI tổng hợp, cho dù đó là GPU hay đó là chip của chính Amazon mà chúng tôi đang thiết kế,” Giám đốc điều hành Amazon Web Services Adam Selipsky cho biết trong một cuộc phỏng vấn vào tháng 6. “Tôi nghĩ rằng chúng tôi đang ở vị trí tốt hơn bất kỳ ai khác trên Trái đất để cung cấp năng lực mà khách hàng của chúng tôi nói chung sẽ muốn.”

Tuy nhiên, những công ty khác đã hành động nhanh hơn và đầu tư nhiều hơn để nắm bắt hoạt động kinh doanh từ sự bùng nổ AI toàn diện. Khi OpenAI ra mắt ChatGPT vào tháng 11, Microsoft đã thu hút được sự chú ý rộng rãi nhờ lưu trữ chatbot lan truyền và đầu tư 13 tỷ đô la được báo cáo vào OpenAI. Công ty đã nhanh chóng thêm các mô hình AI tổng quát vào các sản phẩm của riêng mình, kết hợp chúng vào Bing vào tháng Hai năm nay.

Cùng tháng đó, Google đã ra mắt mô hình ngôn ngữ lớn của riêng mình, Bard, sau đó là khoản đầu tư 300 triệu USD vào đối thủ của OpenAI là Anthropic.

Mãi cho đến tháng 4, Amazon mới công bố dòng mô hình ngôn ngữ lớn của riêng mình, được gọi là Titan, cùng với dịch vụ có tên Bedrock để giúp các nhà phát triển cải tiến phần mềm bằng cách sử dụng AI tổng quát.

“Amazon không quen theo đuổi thị trường. Amazon đã quen với việc tạo ra thị trường. Và tôi nghĩ rằng lần đầu tiên sau một thời gian dài, họ thấy mình đang bị tụt lại phía sau và họ đang nỗ lực để bắt kịp,” Chirag Dekate, phó chủ tịch phân tích của Gartner cho biết.

Meta gần đây cũng đã phát hành mô hình ngôn ngữ lớn (LLM) của riêng mình, Llama 2. Đối thủ ChatGPT mã nguồn mở hiện đã có sẵn để mọi người thử nghiệm trên đám mây công cộng Azure của Microsoft.

Chip là 'sự khác biệt thực sự'

Về lâu dài, Dekate cho biết, chip silicon tùy chỉnh của Amazon có thể mang lại lợi thế cho AI tổng quát.

Ông nói: “Tôi nghĩ rằng sự khác biệt thực sự là khả năng kỹ thuật mà chúng mang lại. “Bởi vì đoán mà xem? Microsoft không có Trainium hay Inferentia,” ông nói.

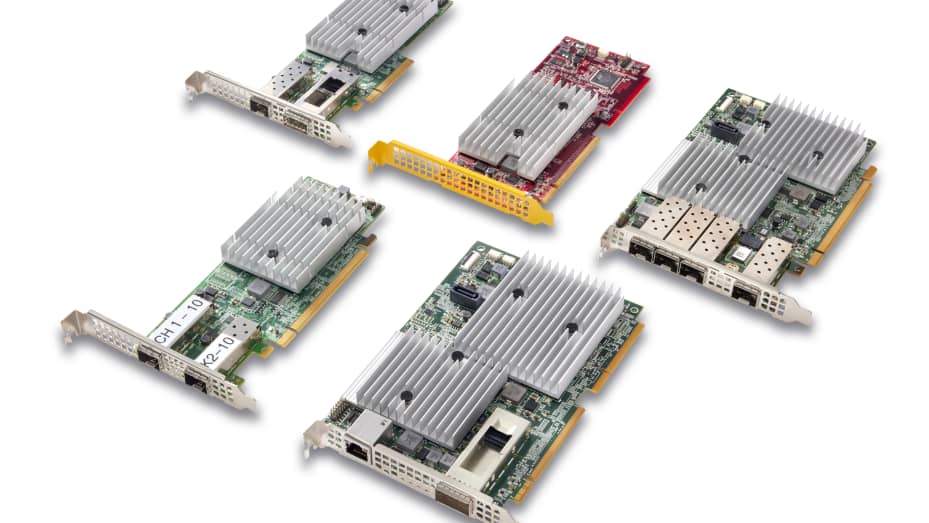

AWS lặng lẽ bắt đầu sản xuất silicon tùy chỉnh vào năm 2013 với một phần cứng chuyên dụng có tên Nitro. Nó hiện là chip AWS có khối lượng lớn nhất. Amazon cho biết, có ít nhất một trong mỗi máy chủ AWS, với tổng số hơn 20 triệu máy đang được sử dụng.

AWS bắt đầu sản xuất silicon tùy chỉnh từ năm 2013 với phần cứng chuyên dụng này có tên là Nitro. Nitro hiện là chip AWS có khối lượng lớn nhất, với ít nhất một chiếc trong mọi máy chủ AWS và tổng cộng hơn 20 triệu lượt sử dụng.

AWS bắt đầu sản xuất silicon tùy chỉnh từ năm 2013 với phần cứng chuyên dụng này có tên là Nitro. Nitro hiện là chip AWS có khối lượng lớn nhất, với ít nhất một chiếc trong mọi máy chủ AWS và tổng cộng hơn 20 triệu lượt sử dụng.

Vào năm 2015, Amazon đã mua công ty khởi nghiệp chip Annapurna Labs của Israel. Sau đó, vào năm 2018, Amazon đã ra mắt chip máy chủ dựa trên Arm, Graviton, đối thủ của CPUx86 từ những gã khổng lồ như AMD và Intel.

“Có lẽ cao từ một chữ số đến có thể 10% tổng doanh số bán máy chủ là của Arm và một phần lớn trong số đó sẽ là của Amazon. Vì vậy, về mặt CPU, họ đã làm khá tốt,” Stacy Rasgon, nhà phân tích cấp cao tại Bernstein Research cho biết.

Cũng trong năm 2018, Amazon đã ra mắt chip tập trung vào AI. Điều đó xảy ra hai năm sau khi Google công bố Bộ xử lý Tensor đầu tiên, hay TPU. Microsoft vẫn chưa công bố chip Athena AI mà họ đang nghiên cứu, được cho là hợp tác với AMD.

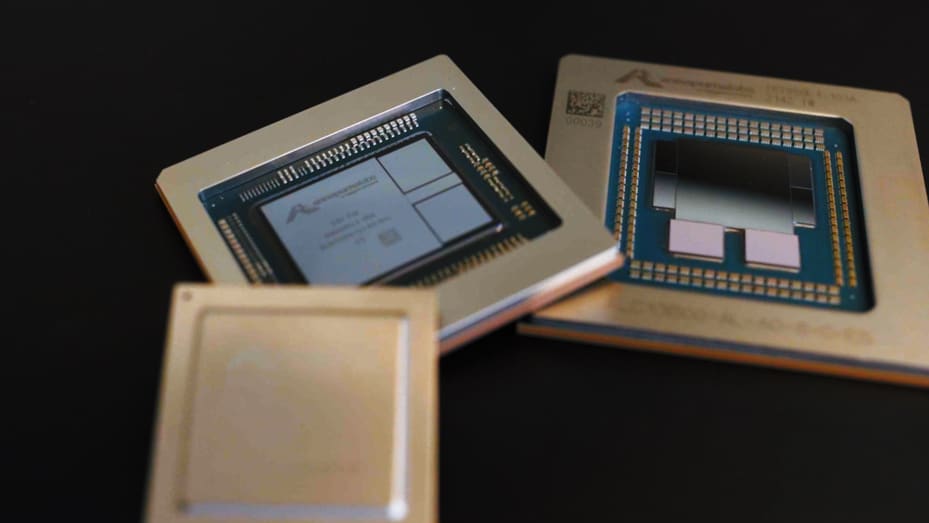

Các phóng viên đã có một chuyến tham quan hậu trường phòng thí nghiệm chip của Amazon ở Austin, Texas, nơi Trainium và Inferentia được phát triển và thử nghiệm. Phó chủ tịch phụ trách sản phẩm Matt Wood giải thích mục đích sử dụng của cả hai con chip. “Học máy chia thành hai giai đoạn khác nhau. Vì vậy, bạn đào tạo các mô hình máy học và sau đó bạn tiến hành suy luận dựa trên các mô hình được đào tạo đó,” Wood nói. “Trainium cải thiện khoảng 50% về hiệu suất giá so với bất kỳ cách đào tạo mô hình máy học nào khác trên AWS.”

Trainium lần đầu tiên xuất hiện trên thị trường vào năm 2021, sau khi phát hành Inferentia vào năm 2019, hiện đang ở thế hệ thứ hai.

Inferentia cho phép khách hàng “cung cấp suy luận máy học với chi phí rất, rất thấp, thông lượng cao, độ trễ thấp, đó là tất cả các dự đoán khi bạn nhập lời nhắc vào mô hình AI tổng quát của mình, đó là nơi tất cả những gì được xử lý để cho bạn câu trả lời,” Wood nói.

Tuy nhiên, hiện tại, GPU của Nvidia vẫn là vua khi nói đến các mô hình đào tạo. Vào tháng 7, AWS đã ra mắt phần cứng tăng tốc AI mới được cung cấp bởi Nvidia H100s.

Rasgon nói: “Các chip Nvidia có một hệ sinh thái phần mềm khổng lồ được xây dựng xung quanh chúng trong 15 năm qua mà không ai khác có được. “Người chiến thắng lớn từ AI hiện nay là Nvidia.”

Các chip tùy chỉnh của Amazon, từ trái sang phải, Inferentia, Trainium và Graviton được trưng bày tại trụ sở chính của Amazon ở Seattle vào ngày 13 tháng 7 năm 2023.

Các chip tùy chỉnh của Amazon, từ trái sang phải, Inferentia, Trainium và Graviton được trưng bày tại trụ sở chính của Amazon ở Seattle vào ngày 13 tháng 7 năm 2023.

Tận dụng sự thống trị của đám mây

Tuy nhiên, sự thống trị trên nền tảng đám mây của AWS là điểm khác biệt lớn của Amazon. “Amazon không cần phải giành được các tiêu đề. Amazon đã có một cơ sở cài đặt đám mây thực sự mạnh mẽ. Tất cả những gì họ cần làm là tìm ra cách cho phép khách hàng hiện tại của họ mở rộng sang các chuyển động tạo ra giá trị bằng cách sử dụng trí tuệ nhân tạo,” Dekate nói.

Khi lựa chọn giữa Amazon, Google và Microsoft cho AI tổng quát, có hàng triệu khách hàng AWS có thể bị thu hút bởi Amazon vì họ đã quen với nó, chạy các ứng dụng khác và lưu trữ dữ liệu của họ ở đó.

“Đó là một câu hỏi về vận tốc. Mai-Lan Tomsen Bukovec, Phó chủ tịch phụ trách công nghệ tại AWS, giải thích rằng tốc độ di chuyển của các công ty này để phát triển các ứng dụng AI tổng quát này phụ thuộc vào việc bắt đầu từ dữ liệu họ có trong AWS và sử dụng các công cụ máy tính và máy học mà chúng tôi cung cấp.

AWS là nhà cung cấp điện toán đám mây lớn nhất thế giới, với 40% thị phần vào năm 2022, theo nhà nghiên cứu ngành công nghệ Gartner. Mặc dù thu nhập hoạt động đã giảm so với cùng kỳ năm ngoái trong ba quý liên tiếp, nhưng AWS vẫn chiếm 70% tổng lợi nhuận hoạt động 7,7 tỷ USD của Amazon trong quý hai. Biên lợi nhuận hoạt động của AWS trước đây rộng hơn nhiều so với biên lợi nhuận tại Google Cloud.

AWS cũng có một danh mục ngày càng tăng cáccông cụ dành cho nhà phát triển tập trung vào AI tổng quát. “Hãy tua lại đồng hồ trước cả ChatGPT. Không phải là sau khi sự việc xảy ra, chúng tôi đột nhiên vội vàng và đưa ra một kế hoạch bởi vì bạn không thể thiết kế một con chip trong thời gian nhanh như vậy, chứ đừng nói đến việc bạn không thể xây dựng một dịch vụ Bedrock trong vòng 2 đến 3 tháng”, Swami Sivasubramanian, Phó chủ tịch phụ trách cơ sở dữ liệu, phân tích và học máy của AWS cho biết.

Bedrock cung cấp cho khách hàng AWS quyền truy cập vào các mô hình ngôn ngữ lớn do Anthropic, Stability AI, AI21 Labs và Titan của Amazon tạo ra. “Chúng tôi không tin rằng một mô hình sẽ thống trị thế giới và chúng tôi muốn khách hàng của mình có những mô hình hiện đại nhất từ nhiều nhà cung cấp vì họ sẽ chọn công cụ phù hợp cho công việc phù hợp,” Sivasubramanian nói.

Một nhân viên của Amazon làm việc trên chip AI tùy chỉnh, trong chiếc áo khoác có nhãn hiệu chip Inferentia của AWS, tại phòng thí nghiệm chip AWS ở Austin, Texas, vào ngày 25 tháng 7 năm 2023.

Một nhân viên của Amazon làm việc trên chip AI tùy chỉnh, trong chiếc áo khoác có nhãn hiệu chip Inferentia của AWS, tại phòng thí nghiệm chip AWS ở Austin, Texas, vào ngày 25 tháng 7 năm 2023.

Một trong những dịch vụ AI mới nhất của Amazon là AWS HealthScribe, một dịch vụ được ra mắt vào tháng 7 để giúp các bác sĩ phác thảo các bản tóm tắt thăm khám bệnh nhân bằng cách sử dụng AI tổng quát. Amazon cũng có SageMaker, một trung tâm máy học cung cấp các thuật toán, mô hình, v.v.

Một công cụ lớn khác là mã hóa đồng hành CodeWhisperer, mà Amazon cho biết đã cho phép các nhà phát triển hoàn thành nhiệm vụ trung bình nhanh hơn 57%. Năm ngoái, Microsoft cũng đã báo cáo năng suất tăng lên từ người bạn đồng hành viết mã của mình, GitHub Copilot.

Vào tháng 6, AWS đã công bố một “trung tâm” đổi mới AI sáng tạo trị giá 100 triệu đô la.

“Chúng tôi có rất nhiều khách hàng nói rằng, 'Tôi muốn làm AI sáng tạo', nhưng họ không nhất thiết phải biết điều đó có ý nghĩa gì đối với họ trong bối cảnh doanh nghiệp của chính họ. Vì vậy, chúng tôi sẽ mời các kiến trúc sư, kỹ sư giải pháp, nhà chiến lược và nhà khoa học dữ liệu làm việc trực tiếp với họ”, Giám đốc điều hành AWS Selipsky cho biết.

Mặc dù cho đến nay AWS chủ yếu tập trung vào các công cụ thay vì xây dựng đối thủ cạnh tranh với ChatGPT, nhưng một email nội bộ bị rò rỉ gần đây cho thấy Giám đốc điều hành Amazon Andy Jassy cũng đang trực tiếp giám sát một nhóm trung tâm mới xây dựng các mô hình ngôn ngữ lớn mở rộng.

Trong báo cáo thu nhập quý hai, Jassy cho biết “một lượng rất đáng kể” hoạt động kinh doanh của AWS hiện được thúc đẩy bởi AI và hơn 20 dịch vụ máy học mà công ty này cung cấp. Một số ví dụ về khách hàng bao gồm Philips, 3M, Old Mutual và HSBC.

Sự phát triển bùng nổ của AI đi kèm với hàng loạt lo ngại về bảo mật từ các công ty lo lắng rằng nhân viên đang đưa thông tin độc quyền vào dữ liệu đào tạo được sử dụng bởi các mô hình ngôn ngữ lớn công khai.

“Tôi không thể cho bạn biết tôi đã nói chuyện với bao nhiêu công ty trong danh sách Fortune 500 đã cấm ChatGPT. Vì vậy, với cách tiếp cận AI tổng quát và dịch vụ Bedrock của chúng tôi, bất kỳ điều gì bạn làm, bất kỳ mô hình nào bạn sử dụng thông qua Bedrock sẽ nằm trong môi trường đám mây riêng ảo biệt lập của riêng bạn. Nó sẽ được mã hóa, nó sẽ có cùng các biện pháp kiểm soát truy cập AWS,” Selipsky nói.

Hiện tại, Amazon chỉ đang tăng tốc thúc đẩy AI tổng quát, và cho biết rằng “hơn 100.000” khách hàng đang sử dụng máy học trên AWS hiện nay. Mặc dù đó là một tỷ lệ nhỏ trong số hàng triệu khách hàng của AWS, nhưng các nhà phân tích cho rằng điều đó có thể thay đổi.

“Những gì chúng tôi không thấy là các doanh nghiệp nói, 'Ồ, đợi một chút, Microsoft đang dẫn đầu về trí tuệ nhân tạo, chúng ta hãy ra ngoài và chuyển đổi chiến lược cơ sở hạ tầng của mình, chuyển mọi thứ sang Microsoft.' Dekate nói. “Nếu bạn đã là khách hàng của Amazon, rất có thể bạn sẽ khám phá hệ sinh thái Amazon khá rộng rãi.”